没有N卡也能使用开源AI大模型

前言

DeepSeek已经发布一段时间了,但是目前的部署教程都是基于NVIDIA的,而 AMD 显卡的兼容性相对较弱,也就没那么多人关心这一部分,今天就来演示如何使用AMD显卡吃上DeepSeek。

注意!!!!

本篇文章只演示我使用的显卡型号------7800XT

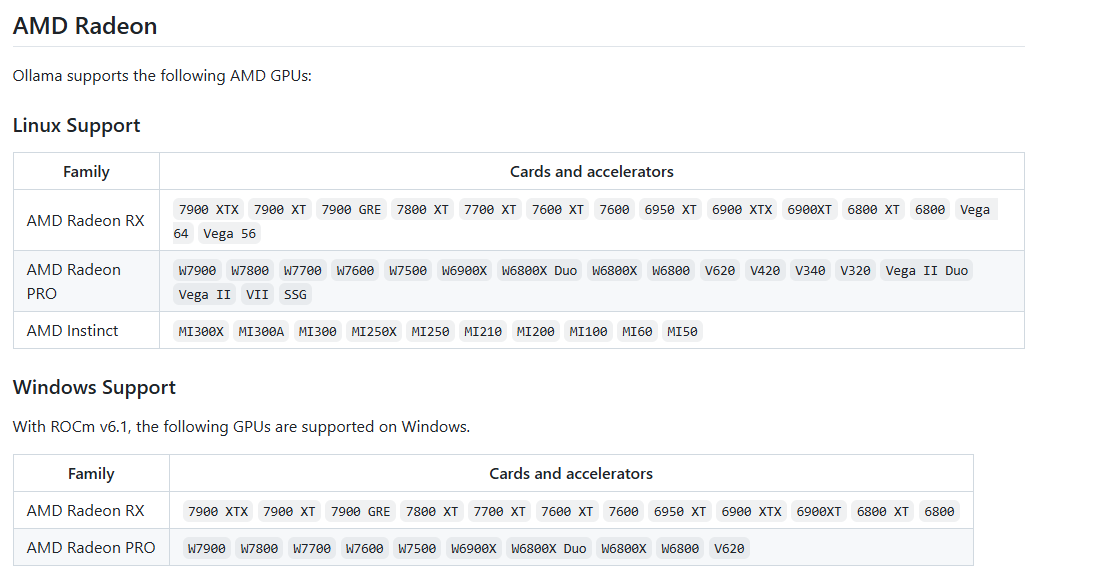

Windows下Ollama支持的显卡型号

打开ollama官方文档可以查看更详细的说明

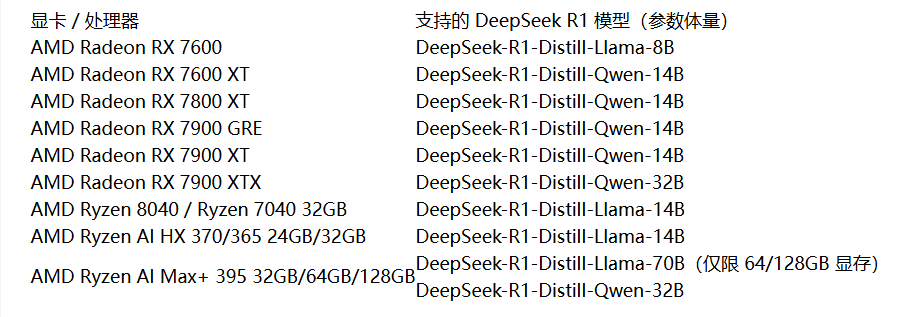

以下是部分消费级显卡型号可使用的模型版本

准备

自行解决网络问题!

步骤

确定显卡型号,演示使用的是7800XT

下载上述驱动并安装。

下载Ollama或者Lm studio并安装。

如你使用Ollama请打开官网,选择你需要的模型,并按照提示运行命令,等待模型下载完成。自行解决网络问题!

如你使用LM studio 它会自行提示让你下载一个适合你的模型,后面你可以更改。

打开任务管理器,查看专用GPU内存是否增加。这样来确定是否为GPU进行加速计算。(一般回答太慢使用的就是CPU,GPU整体都挺快的)

最后

使用AMD显卡本地部署也就完成了,我的7800XT是大概3500块钱买的,性能是不如英伟达4070好,但是性价比相对较高,希望AMD后面能追回来一些吧。这样网络上关于AMD的教程也就越来越多了。

License:

CC BY 4.0